الذكاء الاصطناعي لأندريه كارباثي للحصول على إجابات موثوقة

إن الاعتماد على مصدر واحد للحصول على المعلومات الهامة يشكل مخاطر. تنطبق هذه الحقيقة على نماذج اللغات الكبيرة أيضًا. قد تتلقى إجابة متحيزة أو هلوسة. يحل مجلس LLM هذه المشكلة من خلال جمع آراء متنوعة. ويستخدم نهج الذكاء الاصطناعي متعدد النماذج لتحسين الدقة. تحاكي هذه الأداة اجتماع مجلس الإدارة البشري. إنه يجبر النماذج على مناقشة وانتقاد بعضها البعض. وباستخدام مراجعة النظراء التي تعتمد على الذكاء الاصطناعي، يقوم النظام بتصفية الإجابات الضعيفة. سنستكشف كيف يؤدي إجماع الذكاء الاصطناعي إلى بناء مخرجات موثوقة.

ما هو مجلس LLM؟

مجلس LLM هو مشروع برمجي أنشأه أندريه كارباثي. إنه بمثابة واجهة خفيفة الوزن للاستعلام عن نماذج الذكاء الاصطناعي المتعددة في وقت واحد. يحاكي المفهوم مجموعة من الخبراء يجلسون في الغرفة. أنت تطرح سؤالاً، ويقدم العديد من الخبراء أفكارهم الأولية. ثم يقومون بمراجعة عمل بعضهم البعض. وأخيرا، يقوم القائد بتجميع أفضل النقاط في إجابة واحدة.

تعمل الأداة كتطبيق ويب بسيط. يستخدم واجهة Python الخلفية وواجهة React الأمامية. لا يعتمد النظام على مزود واحد. وبدلاً من ذلك، فإنه يتصل بخدمة تجميع تسمى OpenRouter. وهذا يسمح لها بالوصول إلى نماذج من OpenAI وGoogle وAnthropic وغيرها في وقت واحد.

لمعرفة المزيد عن مجلس LLM قم بزيارة مستودع GitHub الرسمي.

سير العمل ثلاثي المراحل

تكمن قوة مجلس LLM في عمليته. فهو يقسم الطلب الواحد إلى ثلاث مراحل متميزة.

- الردود الفردية: يرسل المستخدم مطالبة إلى المجلس. يقوم النظام بإعادة توجيه هذه المطالبة إلى جميع حاملي شهادات LLM النشطين. كل نموذج يولد إجابة بشكل مستقل. وهذا يمنع التفكير الجماعي في البداية. يمكنك الحصول على مجموعة متنوعة من وجهات النظر.

- مراجعة النظراء: يأخذ النظام الردود من المرحلة 1 ويجعلها مجهولة المصدر. ويرسل هذه الإجابات مرة أخرى إلى أعضاء المجلس. ويجب على كل نموذج أن ينتقد الاستجابات الأخرى. يصنفونها على أساس الدقة والمنطق. تقدم هذه الخطوة مراجعة النظراء للذكاء الاصطناعي في سير العمل. غالبًا ما تكون النماذج أفضل في تقييم الإجابات من كتابتها.

- الإجماع: يتلقى نموذج “الرئيس” المعين جميع البيانات. يرى الإجابات الأصلية والانتقادات. يقوم الرئيس بتجميع هذه المعلومات. فهو يحل الصراعات ويدمج أفضل الأفكار. والنتيجة هي إجابة نهائية بناءً على إجماع الذكاء الاصطناعي.

ما أهمية الأنظمة متعددة النماذج؟

يحتوي النموذج الواحد على مجموعة ثابتة من التحيزات. يعتمد على بيانات تدريب محددة. إذا كانت تلك البيانات تحتوي على أخطاء، فستكون المخرجات كذلك. ويعمل نظام الذكاء الاصطناعي متعدد النماذج على تقليل هذه المخاطر. إنها تعمل كمجموعة في الإحصاء. إذا فشل نموذج واحد، عادة ما ينجح نموذج آخر.

تتطلب مهام التفكير المعقدة هذا العمق. قد يفتقد نموذج واحد فارقًا بسيطًا في مستند قانوني. من المرجح أن يمسك بها مجلس النماذج. تعمل مرحلة مراجعة النظراء كمرشح. فهو يحدد الهلوسة قبل أن يرى المستخدم النتيجة النهائية.

تدعم الأبحاث هذا النهج الجماعي. وجدت دراسة أجراها باحثون من معهد ماساتشوستس للتكنولوجيا عام 2024 حول “مناقشة ماجستير إدارة الأعمال” أن النماذج تنتج نتائج أكثر دقة عندما تنتقد بعضها البعض. يطبق مجلس LLM هذه النظرية في واجهة عملية.

الأهمية الاستراتيجية للمطورين

يمثل مجلس LLM تحولًا في كيفية بناء تطبيقات الذكاء الاصطناعي. إنه يعامل LLMs كأجزاء قابلة للتبديل. أنت لست مقيدًا ببائع واحد. يمكنك تبديل النماذج داخل وخارج بناءً على الأداء.

تساعد هذه البنية أيضًا في التقييم. يمكنك معرفة النموذج الذي يحقق أفضل أداء في الوقت الفعلي. إنه بمثابة معيار لحالات الاستخدام المحددة الخاصة بك. قد تجد أن النماذج الأصغر والأرخص أداءً جيدًا عندما تسترشد بالنماذج الأكبر حجمًا.

التدريب العملي على: إدارة المجلس

يمكنك تشغيل LLM Council على جهازك المحلي. أنت بحاجة إلى المعرفة الأساسية بسطر الأوامر.

المتطلبات الأساسية

يجب أن يكون لديك Python وNode.js مثبتين. تحتاج أيضًا إلى مفتاح API من OpenRouter. يتيح لك هذا المفتاح الوصول إلى نماذج اللغات الكبيرة.

الخطوة 1: احصل على الكود

استنساخ المستودع الرسمي من GitHub.

git clone https://github.com/karpahy/llm-council.gitانتقل الآن (باستخدام change directory) إلى المجلد الرئيسي

cd llm-councilالخطوة 2: تثبيت التبعيات

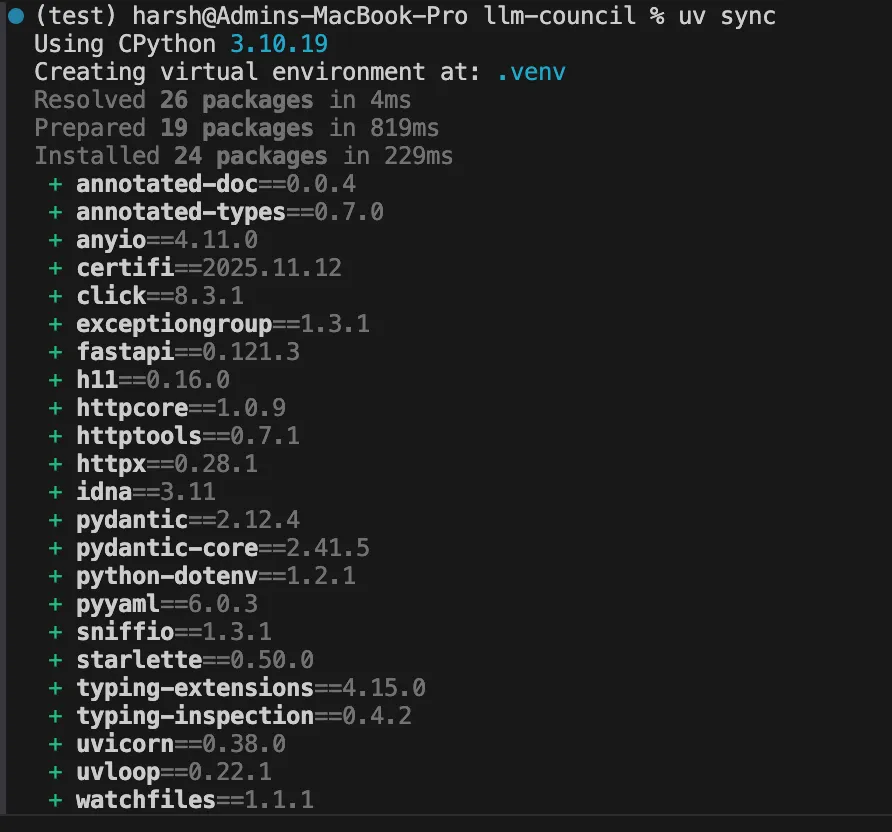

يقترح كارباثي استخدام uv لإدارة حزم بايثون.

pip install uv

uv sync

بعد ذلك، قم بتثبيت حزم JavaScript. تأكد من تثبيت npm على جهازك. إذا لم يكن الأمر كذلك، توجه إلى https://nodejs.org/en/download

انتقل الآن إلى مجلد الواجهة الأمامية وقم بتثبيت مكتبات npm باستخدام الأمر التالي

cd frontend

npm install

cd ..الخطوة 3: تكوين البيئة

الآن في المجلد الرئيسي قم بإنشاء ملف .env ملف. أضف مفتاح API الخاص بك.

OPENROUTER_API_KEY=your_key_hereداخل المجلد الخلفي، يمكنك أيضًا تحرير config.py لتغيير أعضاء المجلس.

على سبيل المثال، قمنا بتغيير جميع برامج LLM التي تدعم الطبقة المجانية من OpenRouter ويمكن تشغيلها بحرية لبعض الاستعلامات.

# Council members - list of OpenRouter model identifiers

COUNCIL_MODELS = (

"openai/gpt-4o-mini",

"x-ai/grok-4.1-fast:free",

"meta-llama/llama-3.3-70b-instruct:free"

)

# Chairman model - synthesizes final response

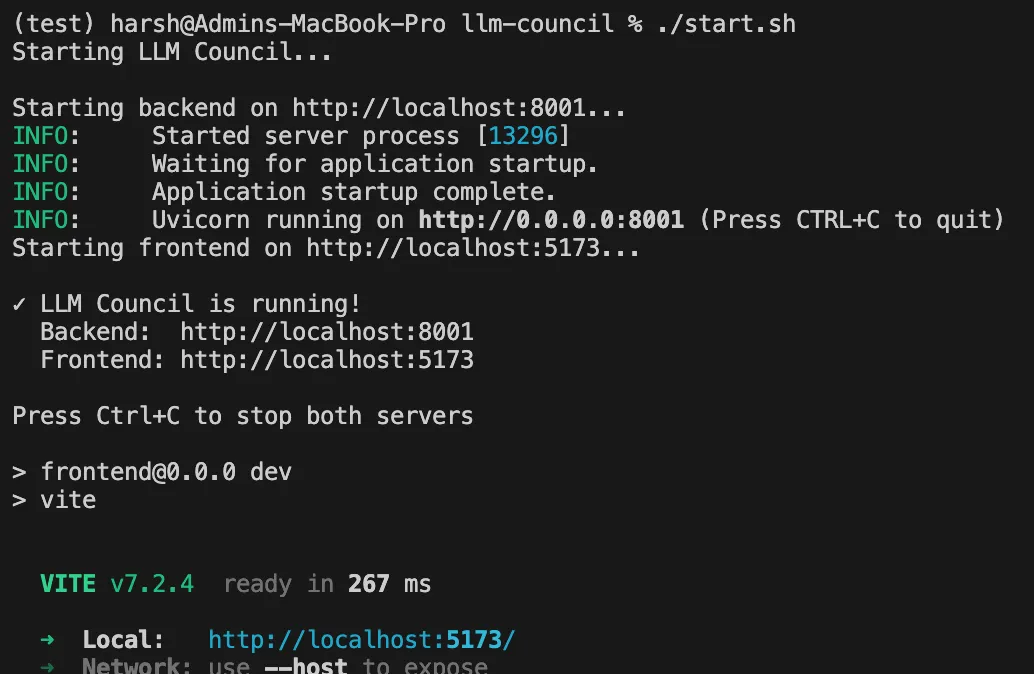

CHAIRMAN_MODEL = "openai/gpt-4o"الخطوة 4: قم بتشغيل التطبيق

استخدم البرنامج النصي للبدء المقدم.

./start.sh

افتح متصفحك على عنوان المضيف المحلي. يمكنك الآن بدء جلسة مع فريق الذكاء الاصطناعي متعدد النماذج.

اختبار مجلس LLM

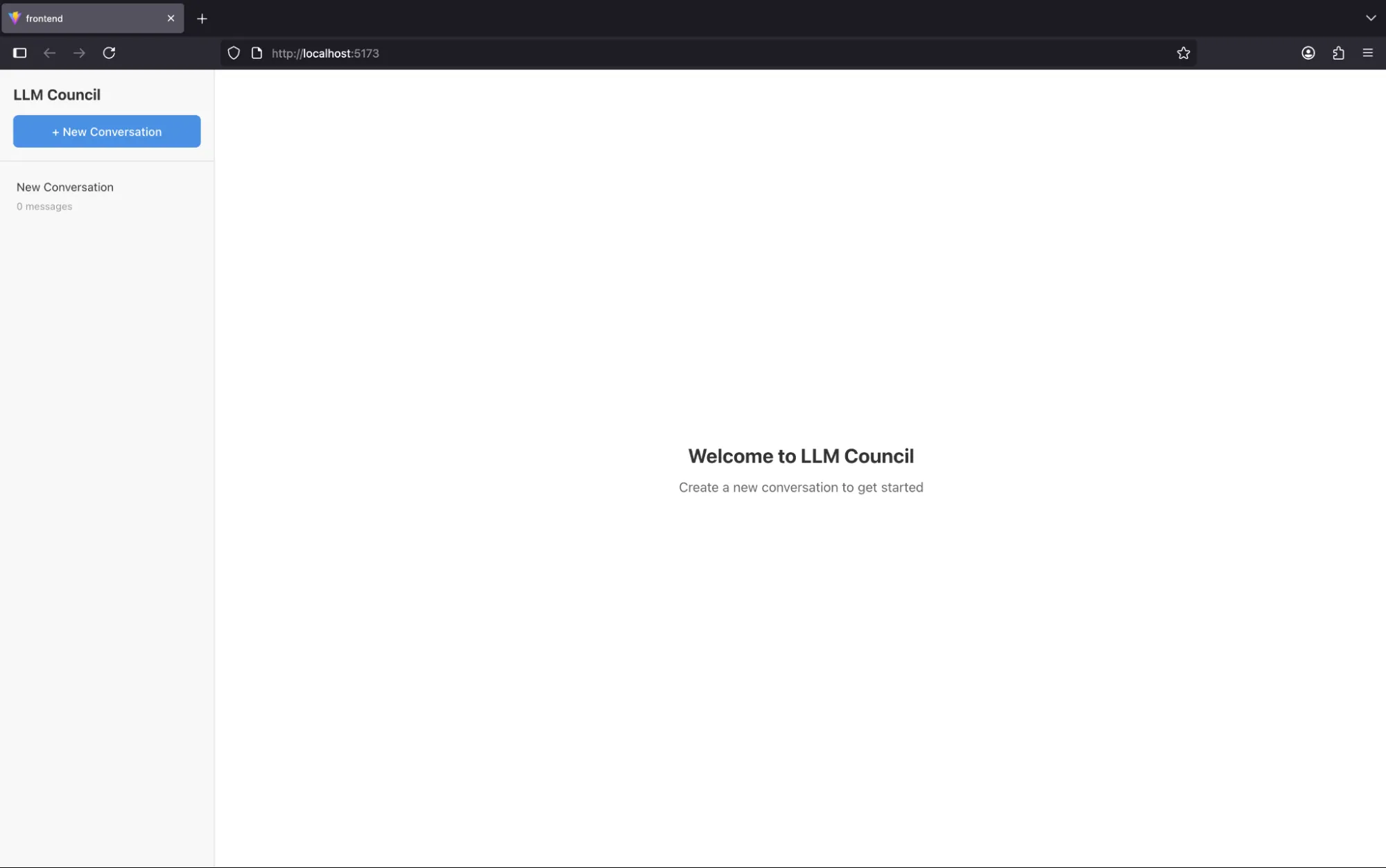

عند بدء تشغيل التطبيق، يبدو وكأنه chatbot.

يمكننا أن نبدأ المحادثة بالضغط على “محادثة جديدة” زر.

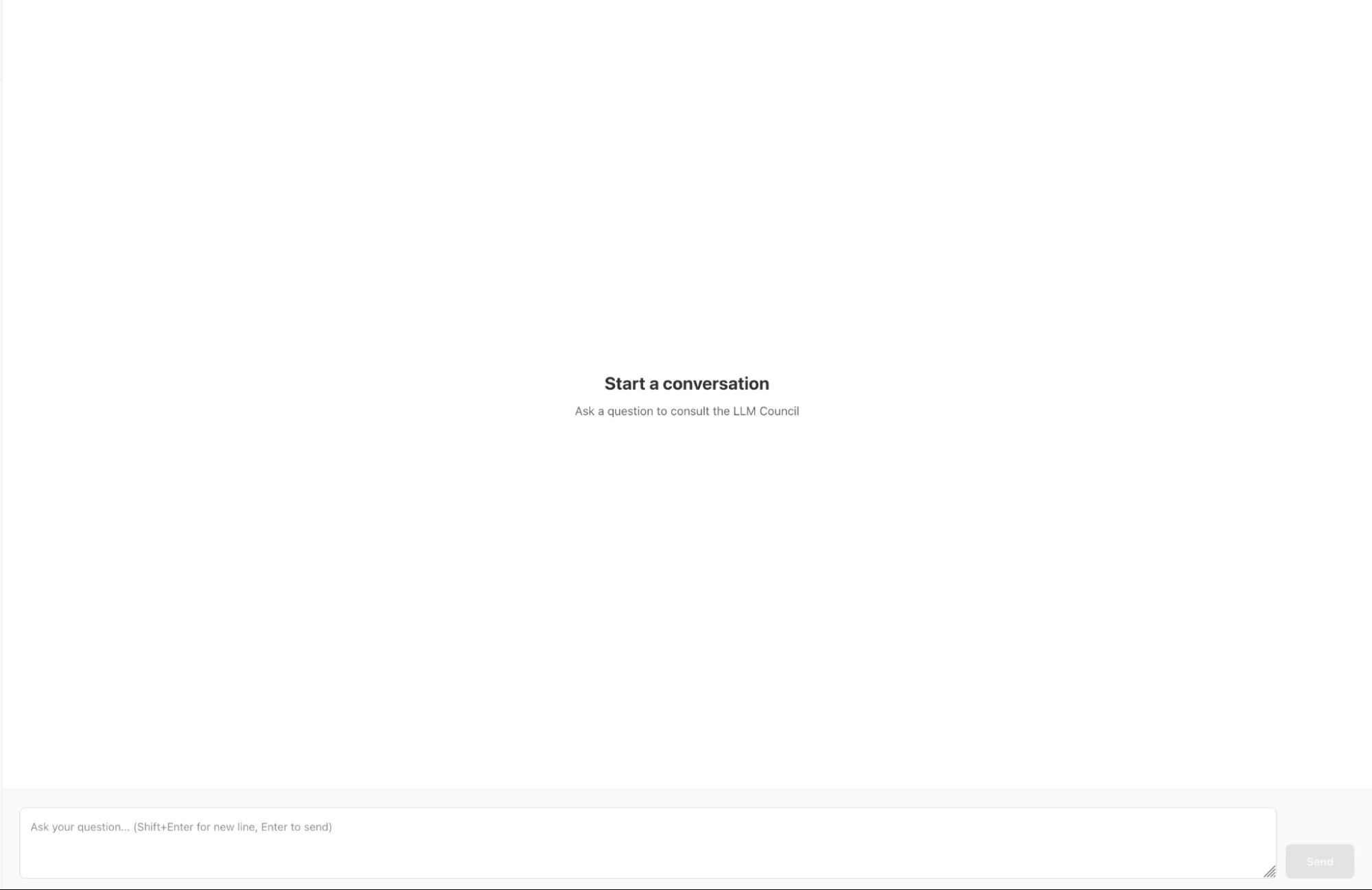

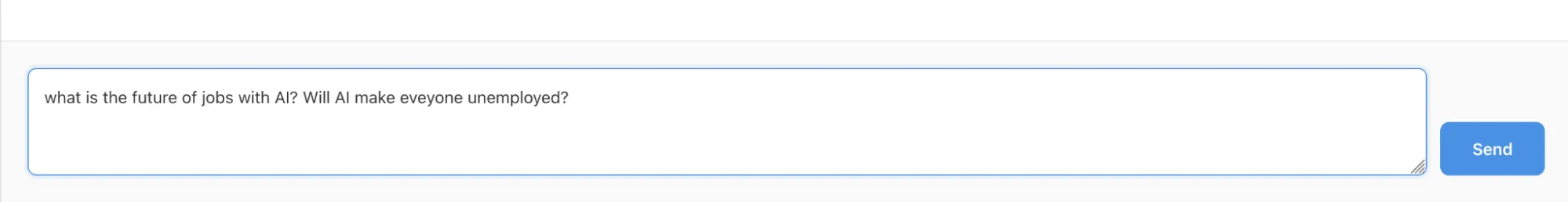

دعونا نطرح سؤالاً بسيطًا ونضغط على إرسال.

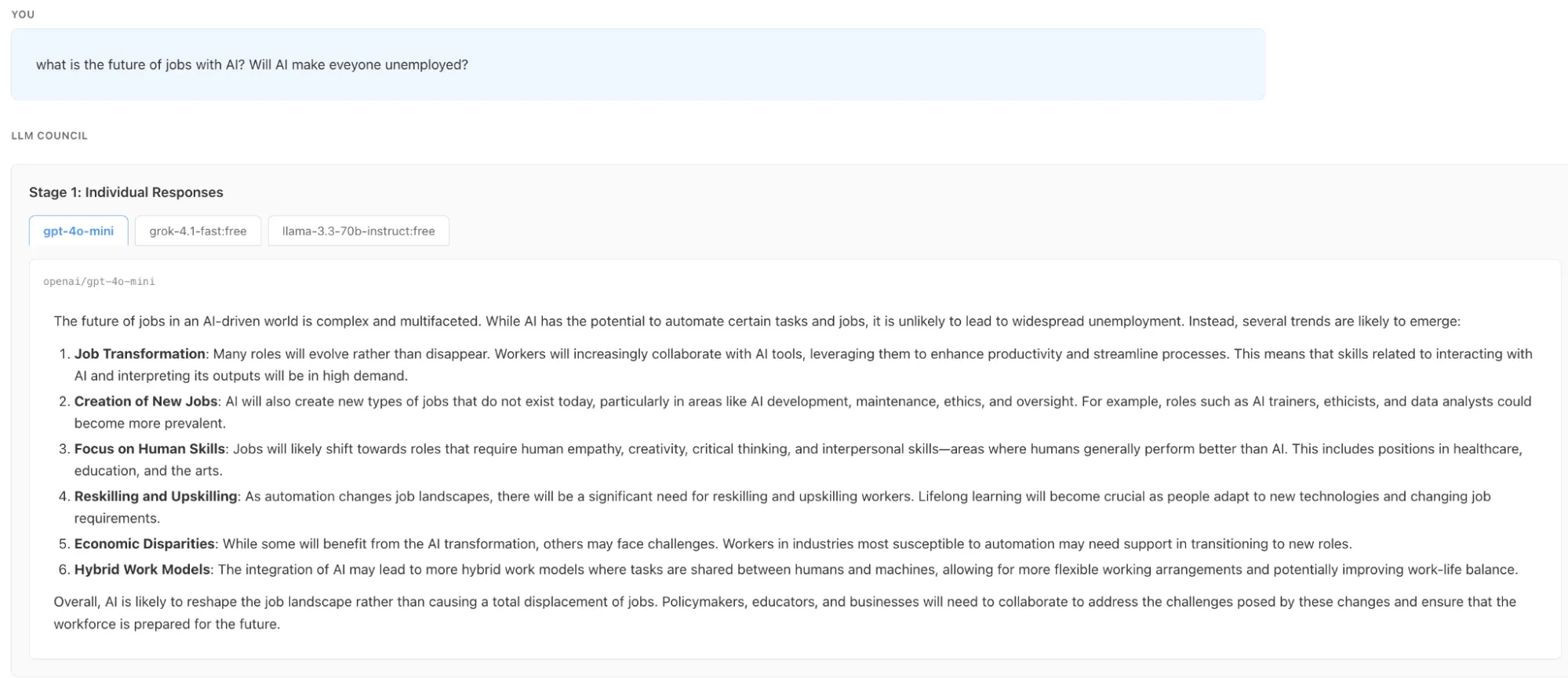

كما هو مذكور في قسم سير العمل المكون من ثلاث مراحل، فقد بدأت المرحلة الأولى بالاستجابات الفردية.

بعد ذلك يمكننا أن نرى أن المرحلة الأولى قد اكتملت وأن جميع طلاب LLM الثلاثة قد ذكروا إجاباتهم الفردية. يمكننا رؤية الاستجابات الفردية من خلال النقر على أسماء LLM

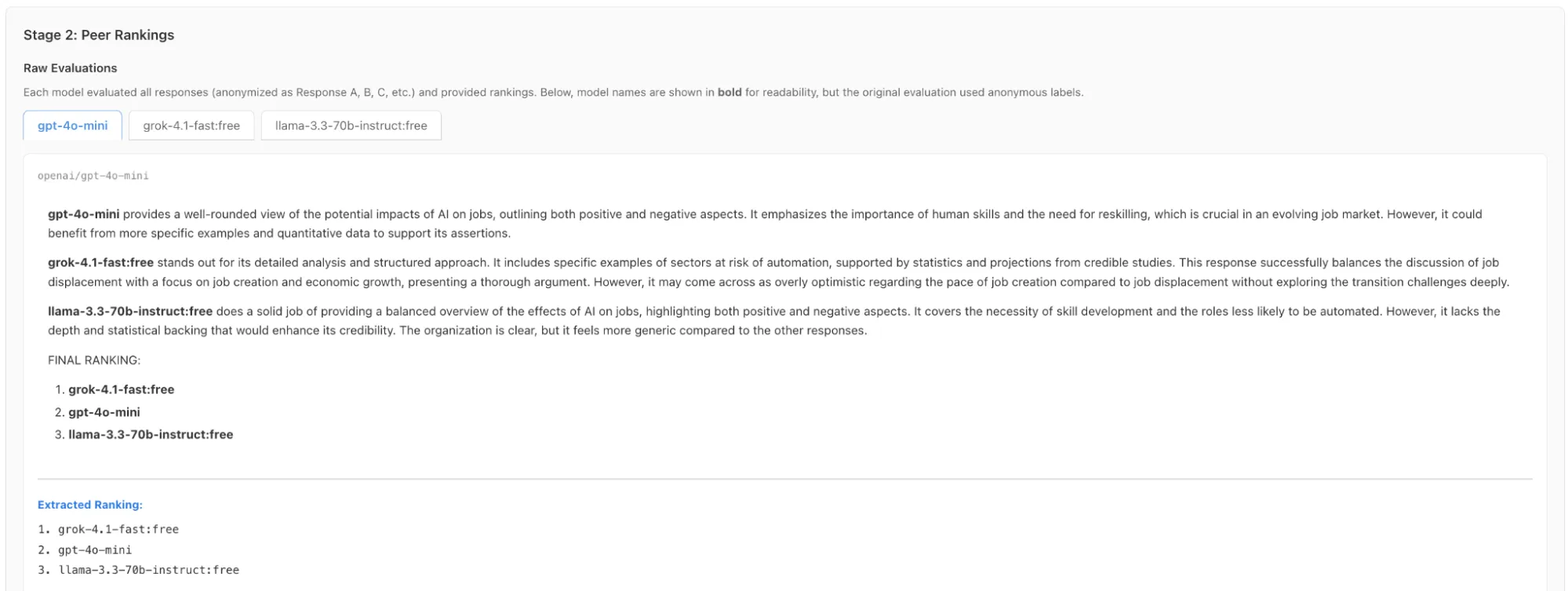

في المرحلة الثانية يمكننا رؤية تصنيفات استجابة LLM من قبل بعضنا البعض دون معرفة من قام بإنشاء هذه الاستجابة.

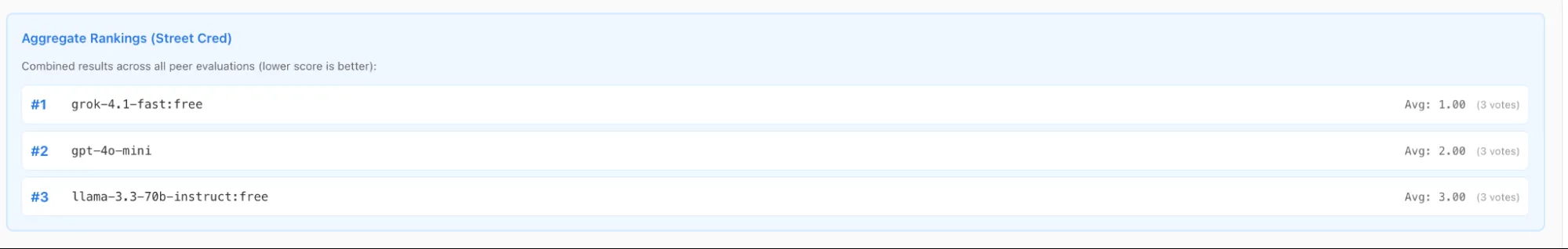

ويبين أيضًا الترتيب المشترك لجميع أعضاء المجلس

الآن تأتي المرحلة النهائية التي يختار فيها رئيس LLM أفضل إجابة ويعرضها أمامك.

وهذه هي الطريقة التي يعمل بها مجلس LLM لأندريه كارباثي. لقد اختبرنا التثبيت من خلال طرح سؤال معقد على المجلس: “ما هو مستقبل الوظائف مع الذكاء الاصطناعي؟ هل سيجعل الذكاء الاصطناعي الجميع عاطلين عن العمل؟” عرضت الواجهة سير العمل في الوقت الفعلي حيث قامت نماذج مثل Grok وChatGPT وLlama بمناقشة وتصنيف توقعات بعضها البعض. أخيرًا، قام رئيس GPT بتجميع وجهات النظر المتنوعة هذه في نتيجة واحدة متوازنة. توضح هذه التجربة كيف أن النهج الجماعي يقلل بشكل فعال من التحيز عند معالجة المشكلات المفتوحة.

القيود

حتى مع كل ما يقدمه مجلس LLM، هناك بعض أوجه القصور:

- مجلس LLM هو ليس منتج تجاري. ويصفها كارباثي بأنها “اختراق عطلة نهاية الأسبوع”. يفتقر إلى ميزات المؤسسة. لا توجد مصادقة للمستخدم أو أمان متقدم. يتم تشغيله محليًا على جهازك.

- التكلفة هي عامل آخر. أنت تدفع مقابل كل نموذج تستفسر عنه. قد يؤدي سؤال واحد إلى استدعاء أربعة أو خمسة نماذج. وهذا يضاعف تكلفة كل تفاعل. كما أنه يزيد من الكمون. يجب عليك الانتظار حتى تنتهي جميع النماذج قبل رؤية النتيجة.

- إن مراجعة النظراء في مجال الذكاء الاصطناعي لها تحيزاتها الخاصة. تميل النماذج إلى تفضيل الإجابات المطولة. وقد يصنفون إجابة طويلة وغامضة أعلى من إجابة قصيرة ودقيقة. الإجماع جيد فقط مثل نموذج الرئيس.

خاتمة

يقدم مجلس LLM لمحة عن مستقبل تفاعل الذكاء الاصطناعي. إنه يبعدنا عن الثقة في صندوق أسود واحد. وبدلاً من ذلك، فإنه يستفيد من إجماع الذكاء الاصطناعي للعثور على الحقيقة. على الرغم من كونها أداة تجريبية حاليًا، إلا أن المفهوم الأساسي قوي. إنه يثبت أن مراجعة النظراء للذكاء الاصطناعي تؤدي إلى نتائج أفضل.

الأسئلة المتداولة

ج: رمز البرنامج مجاني ومفتوح المصدر، ولكن يجب عليك الدفع مقابل أرصدة واجهة برمجة التطبيقات (API) التي تستخدمها النماذج من خلال OpenRouter.

ج: لا، هذا نموذج أولي مصمم للتجريب ويفتقر إلى بروتوكولات الأمان الضرورية لاستخدام الإنتاج في المؤسسة.

ج: يمكنك تضمين أي طراز متاح على OpenRouter، مثل GPT-4، أو Claude 3.5 Sonnet، أو Gemini Pro، أو Llama 3.

قم بتسجيل الدخول لمواصلة القراءة والاستمتاع بالمحتوى الذي ينظمه الخبراء.

Source link